gennemgå budget er antallet af sider søgemaskiner vil gennemgå på en hjemmeside inden for en bestemt tidsramme.

søgemaskiner beregner gennemsøgningsbudget baseret på gennemsøgningsgrænse (hvor ofte de kan gennemgå uden at forårsage problemer) og gennemsøgningsbehov (hvor ofte de gerne vil gennemgå et sted).

hvis du spilder gennemsøgningsbudget, vil søgemaskiner ikke være i stand til at gennemgå din hjemmeside effektivt, hvilket ville ende med at skade din SEO-ydeevne.

- Hvad er gennemsøgningsbudget?

- hvorfor tildeler søgemaskiner gennemsøgningsbudget til hjemmesider?

- hvordan tildeler de gennemsøgningsbudget til hjemmesider?

- er gennemsøgningsbudget kun om sider?

- Hvordan fungerer gennemsøgningsgrænse / værtsbelastning i praksis?

- Hvordan fungerer gennemsøgningsefterspørgsel / gennemsøgningsplanlægning i praksis?

- glem ikke: gennemsøgningskapacitet i selve systemet

- hvorfor skal du bekymre dig om gennemsøgningsbudget?

- Hvad er gennemsøgningsbudgettet for min hjemmeside?

- gennemgå budget i Google Search Console

- gå til kilden: serverlogfiler

- hvordan optimerer du dit gennemsøgningsbudget?

- tilgængelige URL ‘er med parametre

- Duplicate content

- indhold af lav kvalitet

- Broken og omdirigere links

- forkerte URL ‘er i sitemaps

- ContentKing

- sider med høje belastningstider / timeouts

- højt antal ikke-indekserbare sider

- dårlig intern linkstruktur

- Hvordan øger du din hjemmesides gennemsøgningsbudget?

- ofte stillede spørgsmål om gennemsøgningsbudget

- 1. Hvad er et gennemsøgningsbudget?

- 2. Hvordan øger jeg mit gennemsøgningsbudget?

- 3. Hvad kan begrænse mit gennemsøgningsbudget?

- 4. Skal jeg overhovedet bruge canonical URL og meta robots?

Hvad er gennemsøgningsbudget?

gennemgå budget er antallet af sider søgemaskiner vil kravle på en hjemmeside inden for en bestemt tidsramme.

hvorfor tildeler søgemaskiner gennemsøgningsbudget til hjemmesider?

fordi de ikke har ubegrænsede ressourcer, og de deler deres opmærksomhed på tværs af millioner af hjemmesider. Så de har brug for en måde at prioritere deres gennemsøgningsindsats på. Tildeling gennemgang budget til hver hjemmeside hjælper dem med at gøre dette.

hvordan tildeler de gennemsøgningsbudget til hjemmesider?

det er baseret på to faktorer, kravl grænse og kravl efterspørgsel:

- Kravl grænse / vært belastning: hvor meget gennemsøgning kan en hjemmeside håndtere, og hvad er dens ejers præferencer?

- gennemgå efterspørgsel / gennemsøgningsplanlægning: hvilke URL ‘ er er værd at (gen)gennemgå mest, baseret på dens popularitet og hvor ofte den opdateres.

Gennemsøgningsbudget er et almindeligt udtryk inden for SEO. Gennemsøgningsbudget kaldes undertiden også gennemsøgningsrum eller gennemsøgningstid.

er gennemsøgningsbudget kun om sider?

det er faktisk ikke af hensyn til lethed, vi taler om sider, men i virkeligheden handler det om ethvert dokument, som søgemaskiner gennemsøger. Nogle eksempler på andre dokumenter: JavaScript-og CSS-filer, mobile sidevarianter, hreflang varianter og PDF-filer.

Hvordan fungerer gennemsøgningsgrænse / værtsbelastning i praksis?

Kravl grænse, eller vært belastning, hvis du vil, er en vigtig del af gennemgang budget. Søgemaskiner er designet til at forhindre overbelastning af en internetserver med anmodninger, så de er forsigtige med dette.Hvordan søgemaskiner bestemme gennemgang grænse for en hjemmeside? Der er en række faktorer, der påvirker gennemsøgningsgrænsen. For at nævne nogle få:

- tegn på platform i dårlig form: hvor ofte anmodede URL ‘ er timeout eller returner serverfejl.

- mængden af hjemmesider, der kører på værten: hvis din hjemmeside kører på en delt hostingplatform med hundredvis af andre hjemmesider, og du har en ret stor hjemmeside, er gennemgangsgrænsen for din hjemmeside meget begrænset, da gennemgangsgrænsen bestemmes på værtsniveau. Du er nødt til at dele værtens gennemgang grænse med alle de andre steder, der kører på det. I dette tilfælde ville du være langt bedre på en dedikeret server, hvilket sandsynligvis også massivt reducerer belastningstiderne for dine besøgende.

en anden ting at overveje er at have separate mobil-og desktopsider, der kører på den samme vært. De har også en fælles gennemsøgningsgrænse. Så husk dette.

gennemsøger søgemaskiner de vigtigste dele af din hjemmeside? Kør en hurtig test med ContentKing!

Hvordan fungerer gennemsøgningsefterspørgsel / gennemsøgningsplanlægning i praksis?

Kravl efterspørgsel, eller gennemsøgningsplanlægning, handler om at bestemme værdien af re-kravlende URL ‘ er. Igen påvirker mange faktorer kravefterspørgsel, blandt hvilke:

- Popularitet: hvor mange indgående interne og indgående Eksterne links en URL har, men også mængden af forespørgsler, den rangerer for.

- friskhed: hvor ofte URL ‘ en opdateres.

- sidetype: er den type side, der sandsynligvis vil ændre sig. Tag for eksempel en produktkategoriside og en side med vilkår og betingelser – hvilken synes du ændrer oftest og fortjener at blive gennemsøgt oftere?

at tvinge Googles søgere til at vende tilbage til din hjemmeside, når der ikke er noget vigtigere at finde (dvs.meningsfuld ændring), er ikke en god strategi, og de er ret kloge til at finde ud af, om hyppigheden af disse sider ændrer sig faktisk tilføjer værdi. Det bedste råd, jeg kunne give, er at koncentrere mig om at gøre siderne vigtigere (tilføje mere nyttige oplysninger, gøre sidernes indhold rig (de vil naturligvis udløse flere forespørgsler som standard, så længe fokus for et emne opretholdes). Ved naturligt at udløse flere forespørgsler som en del af’ tilbagekaldelse ‘ (indtryk) gør du dine sider vigtigere og se og se: du vil sandsynligvis blive gennemsøgt hyppigere.

glem ikke: gennemsøgningskapacitet i selve systemet

mens søgemaskinens gennemsøgningssystemer har massiv gennemsøgningskapacitet, er det i slutningen af dagen begrænset. Så i et scenarie, hvor 80% af Googles datacentre går offline på samme tid, falder deres gennemsøgningskapacitet massivt og til gengæld alle hjemmesiders gennemsøgningsbudget.

massiv tak til daggry Anderson (åbner i en ny fane) for at give os detaljer om gennemsøgningsgrænse, gennemsøgningsbehov og gennemsøgningskapacitet!

hvorfor skal du bekymre dig om gennemsøgningsbudget?

du vil have søgemaskiner til at finde og forstå så mange som muligt af dine indekserbare sider, og du vil have dem til at gøre det så hurtigt som muligt. Når du tilføjer nye sider og opdaterer eksisterende, vil du have søgemaskiner til at hente disse så hurtigt som muligt. Jo før de har indekseret siderne, jo hurtigere kan du drage fordel af dem.

hvis du spilder gennemgå budget, søgemaskiner vil ikke være i stand til at gennemgå din hjemmeside effektivt. De vil bruge tid på dele af din hjemmeside, der ikke betyder noget, hvilket kan resultere i, at vigtige dele af din hjemmeside bliver uopdaget. Hvis de ikke kender til sider, vil de ikke gennemgå og indeksere dem, og du vil ikke være i stand til at bringe besøgende ind gennem søgemaskiner til dem.

du kan se, hvor dette fører til: spild af gennemsøgningsbudget gør ondt i din SEO-ydeevne.

bemærk, at gennemsøgningsbudget generelt kun er noget at bekymre sig om, hvis du har en stor hjemmeside, lad os sige 10.000 sider og opefter.

et af de mere undervurderede aspekter af gennemsøgningsbudget er belastningshastighed. En hurtigere loading hjemmeside betyder, at Google kan gennemgå flere URL ‘ er på samme tid. For nylig var jeg involveret i en site opgradering, hvor belastningshastigheden var et stort fokus. Den nye side indlæses dobbelt så hurtigt som den gamle. Da det blev skubbet live, steg antallet af URL ‘ er, som Google gennemsøgte om dagen, fra 150.000 til 600.000 – og blev der. For et sted af denne størrelse og omfang betyder den forbedrede gennemsøgningshastighed, at nyt og ændret indhold gennemsøges meget hurtigere, og vi ser en meget hurtigere indvirkning af vores SEO-indsats i SERP ‘ er.

en meget klog SEO (okay, det var AJ Kohn (åbner i en ny fane)) sagde engang berømt “du er hvad Googlebot spiser.”. Dine placeringer og søgesynlighed er direkte relateret til ikke kun, hvad Google gennemsøger på din side, men ofte, hvor ofte de gennemsøger det. Hvis Google savner indhold på din hjemmeside, eller ikke gennemgår vigtige URL ‘ er ofte nok på grund af begrænset/ikke-optimeret gennemsøgningsbudget, så vil du have en meget hård tid ranking faktisk. For større sider kan optimering af gennemsøgningsbudget i høj grad øge profilen på tidligere usynlige sider. Mens mindre site nødt til at bekymre sig mindre om gennemgang budget, de samme principper for optimering (hastighed, prioritering, link struktur, de-duplikering, etc.) kan stadig hjælpe dig med at rangere.

jeg er mest enig med Google, og for det meste behøver mange hjemmesider ikke at bekymre sig om gennemsøgningsbudget. Men for hjemmesider, der er store i størrelse og især dem, der opdateres ofte, såsom udgivere, kan optimering gøre en betydelig forskel.

Hvad er gennemsøgningsbudgettet for min hjemmeside?

ud af alle søgemaskiner, Google er den mest gennemsigtige om deres gennemgang budget til din hjemmeside.

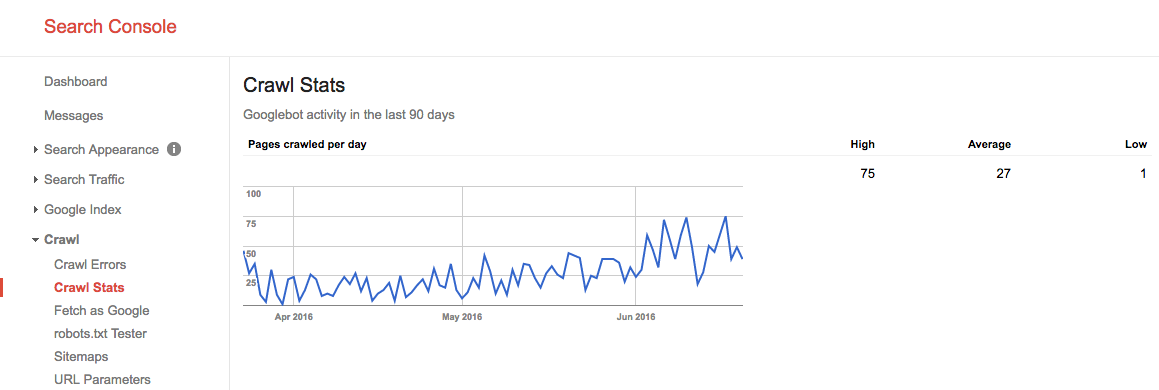

gennemgå budget i Google Search Console

hvis du har bekræftet din hjemmeside i Google Search Console, kan du få et indblik i din hjemmesides gennemsøgningsbudget for Google.

Følg disse trin:

- Log ind på Google Search Console og vælg en hjemmeside.

- gå til

Crawl>Crawl Stats. Der kan du se antallet af sider, som Google gennemsøger om dagen.

i løbet af sommeren 2016 så vores gennemsøgningsbudget sådan ud:

vi ser her, at det gennemsnitlige gennemsøgningsbudget er 27 sider / dag. Så i teorien, hvis dette gennemsnitlige gennemsøgningsbudget forbliver det samme, ville du have et månedligt gennemsøgningsbudget på 27 sider 30 dage = 810 sider.

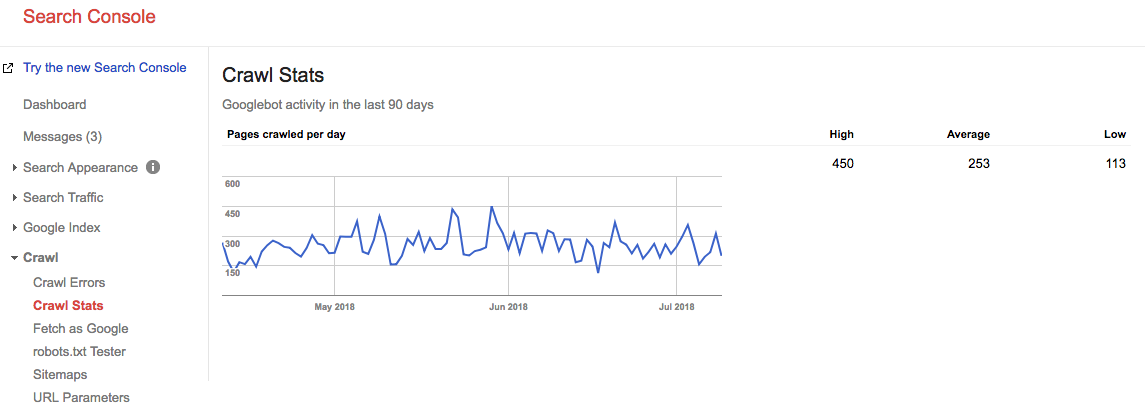

hurtigt frem 2 år, og se på, hvad vores gennemsøgningsbudget er lige nu:

vores gennemsnitlige gennemsnitlige gennemsøgningsbudget er 253 sider / dag, så du kan sige, at vores gennemsøgningsbudget steg 10 gange om 2 år.

gå til kilden: serverlogfiler

det er meget interessant at tjekke dine serverlogfiler for at se, hvor ofte Googles gennemsøgere rammer din hjemmeside. Det er interessant at sammenligne disse statistikker med dem, der rapporteres i Google Search Console. Det er altid bedre at stole på flere kilder.

lad ikke gennemsøgningsproblemer være en forpasset mulighed. Løbende overvåge din hjemmeside med ContentKing og blive advaret om problemer i realtid.

hvordan optimerer du dit gennemsøgningsbudget?

optimering af dit gennemsøgningsbudget handler om at sikre, at intet gennemsøgningsbudget spildes. I det væsentlige fastsættelse af årsagerne til spildt gennemsøgningsbudget. Vi overvåger tusindvis af hjemmesider; hvis du skulle tjekke hver enkelt af dem for gennemgang budget spørgsmål, ville du hurtigt se et mønster: de fleste hjemmesider lider af den samme slags problemer.

almindelige årsager til spildt gennemsøgningsbudget, som vi støder på:

- tilgængelige URL ‘ er med parametre: et eksempel på en URL med en parameter er

https://www.example.com/toys/cars?color=black. I dette tilfælde bruges parameteren til at gemme en besøgendes valg i et produktfilter. - Duplicate content: vi kalder sider, der er meget ens, eller nøjagtigt det samme, “duplicate content.”Eksempler er: kopierede sider, interne søgeresultatsider og tagsider.

- indhold af lav kvalitet: sider med meget lidt indhold eller sider, der ikke tilføjer nogen værdi.

- ødelagte og omdirigerende links: ødelagte links er links, der henviser til sider, der ikke findes længere, og omdirigerede links er links til URL ‘er, der omdirigerer til andre URL’ er.

- inkludering af forkerte URL ‘er i sitemaps: sider, der ikke kan indekseres, og sider, der ikke kan indekseres, f.eks. 3, 4 og 5 URL’ er, bør ikke medtages i sitemap.

- sider med høj load time / time-outs: sider, der tager lang tid at indlæse eller slet ikke indlæses, har en negativ indvirkning på dit gennemsøgningsbudget, fordi det er et tegn til søgemaskiner, at din hjemmeside ikke kan håndtere anmodningen, og så de kan justere din gennemsøgningsgrænse.

- et stort antal sider, der ikke kan indekseres: hjemmesiden indeholder mange sider, der ikke kan indekseres.

- dårlig intern linkstruktur: hvis din interne linkstruktur ikke er konfigureret korrekt, er søgemaskiner muligvis ikke opmærksomme nok på nogle af dine sider.

jeg har ofte sagt, at Google er som din chef. Du ville ikke gå ind i et møde med din chef, medmindre du vidste, hvad du skulle tale om, højdepunkterne i dit arbejde, målene for dit møde. Kort sagt, du har en dagsorden. Når du går ind i Googles “kontor”, har du brug for det samme. Et klart stedhierarki uden meget cruft, et nyttigt sitemap og hurtige responstider vil alle hjælpe Google med at komme til det, der er vigtigt. Overse ikke dette ofte misforståede element i SEO.

for mig er begrebet gennemsøgningsbudget et af nøglepunkterne i teknisk SEO. Når du optimerer til gennemsøgningsbudget, falder alt andet på plads: intern sammenkædning, fastsættelse af fejl, sidehastighed, URL-optimering, indhold af lav kvalitet og mere. Folk bør grave i deres logfiler oftere for at overvåge gennemsøgningsbudget for specifikke URL ‘ er, underdomæner, bibliotek osv. Overvågning af gennemsøgningsfrekvens er meget relateret til gennemsøgningsbudget og super kraftig.

tilgængelige URL ‘er med parametre

i de fleste tilfælde bør URL’ er med parametre ikke være tilgængelige for søgemaskiner, fordi de kan generere en næsten uendelig mængde URL ‘ er.Vi har skrevet meget om denne type problemer i vores artikel om bæltefælder.

URL ‘ er med parametre bruges ofte ved implementering af produktfiltre på e-handelssider. Det er fint at bruge dem,; bare sørg for, at de ikke er tilgængelige for søgemaskiner.

Hvordan kan du gøre dem utilgængelige for søgemaskine?

- Brug dine robotter.at instruere søgemaskiner om ikke at få adgang til sådanne URL ‘ er. Hvis dette af en eller anden grund ikke er en mulighed, skal du bruge indstillingerne for håndtering af URL-parametre i Google Search Console og Bing til at instruere Google og Bing om, hvilke sider der ikke skal gennemsøges.

- Tilføj attributværdien nofølg til links på filterlinks. Bemærk, at fra marts 2020 kan Google vælge at ignorere nofølgen. Derfor er trin 1 Endnu vigtigere.

Duplicate content

du ønsker ikke, at søgemaskinen bruger deres tid på sider med duplikeret indhold, så det er vigtigt at forhindre eller i det mindste minimere det duplikerede indhold på din side.

Hvordan gør du det? Af…

- opsætning af omdirigeringer til alle domænevarianter (

HTTP,HTTPS,non-WWW, ogWWW). - gør interne søgeresultatsider utilgængelige for søgemaskiner ved hjælp af dine robotter.TST. Her er et eksempel på robotter.for at få en hjemmeside.

- deaktivering af dedikerede sider til billeder (f.eks.

- vær forsigtig omkring din brug af taksonomier såsom kategorier og tags.

tjek nogle mere tekniske grunde til duplikatindhold, og hvordan du løser dem.

indhold af lav kvalitet

sider med meget lidt indhold er ikke interessante for søgemaskiner. Hold dem på et minimum, eller undgå dem helt, hvis det er muligt. Et eksempel på indhold af lav kvalitet er et Ofte stillede spørgsmål med links til at vise spørgsmål og svar, hvor hvert spørgsmål og svar serveres over en separat URL.

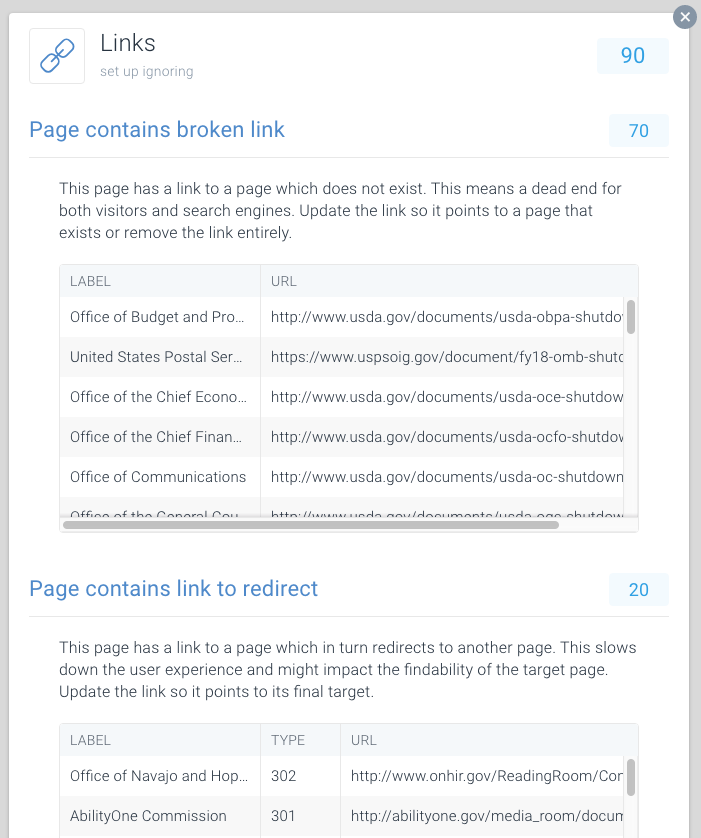

Broken og omdirigere links

Broken links og lange kæder af omdirigeringer er blindgyder for søgemaskiner. Google ser ud til at følge maksimalt fem kædede omdirigeringer i en gennemgang (de genoptager muligvis gennemsøgning senere). Det er uklart, hvor godt andre søgemaskiner håndterer efterfølgende omdirigeringer, men vi anbefaler kraftigt, at du undgår kædede omdirigeringer helt og holder brugen af omdirigeringer til et minimum.

det er klart, at ved at fastsætte brudte links og omdirigere links, kan du hurtigt gendanne spildt gennemgang budget. Udover at gendanne gennemsøgningsbudget forbedrer du også en besøgendes brugeroplevelse markant. Omdirigeringer og kæder af omdirigeringer i særdeleshed forårsager længere sideindlæsningstid og derved skader brugeroplevelsen.

for at gøre det nemt at finde brudte og omdirigere links, har vi dedikeret specielle problemer til dette inden for ContentKing.

gå til Issues > Links for at finde ud af, om du spilder gennemsøgningsbudgetter på grund af defekte links. Opdater hvert link, så det linker til en indekserbar side, eller fjern linket, hvis det ikke længere er nødvendigt.

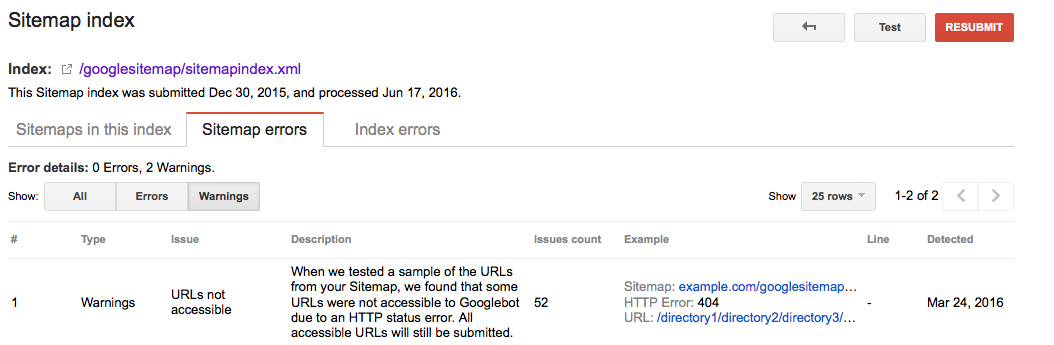

forkerte URL ‘er i sitemaps

alle URL’ er, der er inkluderet i sitemaps, skal være til indekserbare sider. Især med store hjemmesider er søgemaskiner stærkt afhængige af sitemaps for at finde alle dine sider. Hvis dine sitemaps er fyldt med sider, der f.eks. ikke findes længere eller omdirigerer, spilder du gennemsøgningsbudget. Kontroller regelmæssigt dit sitemap for ikke-indekserbare URL ‘ er, der ikke hører hjemme derinde. Kontroller også det modsatte: se efter sider, der er forkert udelukket fra sitemap. Sitemap er en fantastisk måde at hjælpe søgemaskiner med at bruge gennemgå budget klogt.

Google Searche Console

- Log ind på Google Search Console

- Klik på fanen

Crawl - Klik på fanen

Sitemaps

Bing værktøjer

- Log ind på din konto

- Klik på fanen

Configure My Site - Klik på fanen

Sitemaps

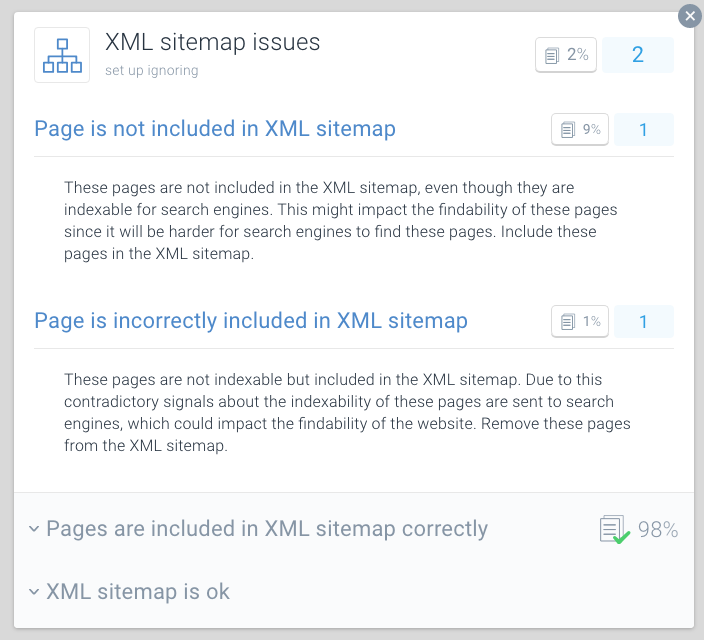

ContentKing

- Log ind på din ContentKing konto

- Klik på

Issuesknappen - Klik på

XML Sitemapknappen - i tilfælde af problemer med din side vil du modtage denne besked:

Page is incorrectly included in XML sitemap

en best practice for optimering af gennemsøgningsbudget er at opdele dine sitemaps i mindre sitemaps. Du kan f.eks. oprette sitemaps for hver af din hjemmesides sektioner. Hvis du har gjort dette, kan du hurtigt afgøre, om der er nogen problemer foregår i visse dele af din hjemmeside.

sig dit sitemap for afsnit A indeholder 500 links, og 480 er indekseret: så gør du det godt. Men hvis dit sitemap for afsnit B indeholder 500 links og kun 120 er indekseret, er det noget at undersøge. Du har muligvis inkluderet en masse ikke-indekserbare URL ‘ er i sitemap for afsnit B.

dårlige forhold for krybere kan skade din SEO. Brug ContentKing til at køre en hurtig revision af din hjemmeside.

sider med høje belastningstider / timeouts

når sider har høje belastningstider eller timeout, kan søgemaskiner besøge færre sider inden for deres tildelte gennemsøgningsbudget til din hjemmeside. Ud over denne ulempe skader høje sideindlæsningstider og timeouts din besøgendes brugeroplevelse betydeligt, hvilket resulterer i en lavere konverteringsfrekvens.

sideindlæsningstider over to sekunder er et problem. Ideelt set indlæses din side på under et sekund. Kontroller regelmæssigt dine sideindlæsningstider med værktøjer som Pingdom (åbnes i en ny fane),

Google rapporterer om sideindlæsningstid i både Google Analytics (under Behavior > Site Speed) Google Search Console under Crawl > Crawl Stats.

Google Search Console og Bing tools rapporterer begge om timeout på siden. I Google Search Console kan dette findes under Crawl > Crawl Errors, og i Bing-værktøjer er det under Reports & Data > Crawl Information.

Kontroller regelmæssigt, om dine sider indlæses hurtigt nok, og tag straks handling, hvis de ikke er det. sider med hurtig indlæsning er vigtige for din online succes.

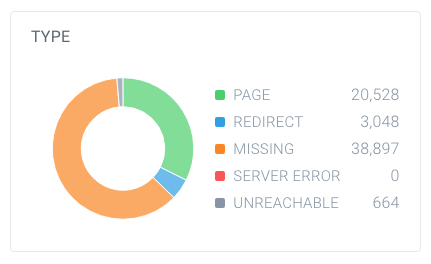

højt antal ikke-indekserbare sider

hvis din hjemmeside indeholder et stort antal ikke-indekserbare sider, der er tilgængelige for søgemaskiner, holder du dybest set søgemaskiner travlt med at sive gennem irrelevante sider.

vi betragter følgende typer som ikke-indekserbare sider:

- omdirigeringer (3%)

- sider, der ikke kan findes (4%)

- sider med serverfejl (5%)

- sider, der ikke kan indekseres (sider, der indeholder robotten)

for at finde ud af, om du har et stort antal sider, der ikke kan indekseres, skal du slå det samlede antal sider op, som gennemsøgere har fundet på din hjemmeside, og hvordan de nedbrydes. Du kan nemt gøre dette ved hjælp af ContentKing:

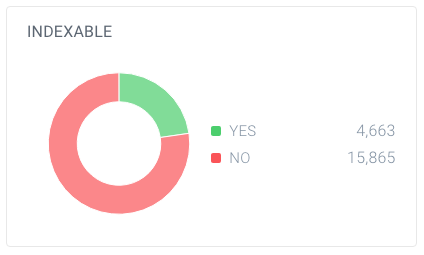

i dette eksempel findes der 63.137 URL ‘ er, hvoraf kun 20.528 er sider.

og ud af disse sider er kun 4.663 indekserbare for søgemaskiner. Kun 7,4% af de URL ‘ er, der findes af ContentKing, kan indekseres af søgemaskiner. Det er ikke et godt forhold, og denne hjemmeside skal helt sikkert arbejde på det ved at rydde op i alle henvisninger til dem, der er unødvendige, herunder:

- (se forrige afsnit)

- Links

- kanoniske URL ‘ er

- hreflang referencer

- Paginationsreferencer (link rel prev / næste)

dårlig intern linkstruktur

hvordan sider på din hjemmeside linker til hinanden spiller en stor rolle i optimering af gennemsøgningsbudget. Vi kalder dette den interne linkstruktur på din hjemmeside. Backlinks til side, sider, der har få Interne links, får meget mindre opmærksomhed fra søgemaskiner end sider, der er knyttet til af mange sider.

undgå en meget hierarkisk linkstruktur, hvor Sider i midten har få links. I mange tilfælde gennemsøges disse sider ikke ofte. Det er endnu værre for sider i bunden af hierarkiet: på grund af deres begrænsede antal links kan de meget vel blive forsømt af søgemaskiner.

sørg for, at dine vigtigste sider har masser af interne links. Sider, der for nylig er gennemsøgt, rangerer typisk bedre i søgemaskiner. Husk dette, og juster din interne linkstruktur til dette.

hvis du for eksempel har en blogartikel fra 2011, der driver en masse organisk trafik, skal du sørge for at fortsætte med at linke til den fra andet indhold. Fordi du har produceret mange andre blogartikler gennem årene, bliver denne artikel fra 2011 automatisk skubbet ned i din hjemmesides interne linkstruktur.

du behøver normalt ikke bekymre dig om gennemsøgningshastigheden på dine vigtige sider. Det er normalt sider, der er nye, som du ikke linkede til, og at folk ikke går til det, kan ikke gennemsøges ofte.

Hvordan øger du din hjemmesides gennemsøgningsbudget?

under en samtale (åbner i en ny fane) mellem Eric Enge og Googles tidligere leder af teamet Matt Cutts, blev forholdet mellem myndighed og gennemsøgningsbudget bragt op:

den bedste måde at tænke over det på er, at antallet af sider, vi gennemgår, er nogenlunde proportional med din PageRank. Så hvis du har mange indgående links på din rodside, vil vi helt sikkert gennemgå det. Så kan din rodside linke til andre sider, og de vil få PageRank, og vi vil også gennemgå dem. Som du får dybere og dybere i din hjemmeside, imidlertid, PageRank tendens til at falde.

selvom Google har forladt opdatering af PageRank-værdier af sider offentligt, tror vi (en form for) PageRank stadig bruges i deres algoritmer. Da PageRank er et misforstået og forvirrende udtryk, lad os kalde det page authority. Take-væk her er, at Matt Cutts dybest set siger: der er et ret stærkt forhold mellem sidemyndighed og gennemsøgningsbudget.

så for at øge din hjemmesides gennemsøgningsbudget skal du øge autoriteten på din hjemmeside. En stor del af dette gøres ved at tjene flere links fra eksterne hjemmesider. Mere information om dette kan findes i vores link building guide.

når jeg hører branchen tale om gennemsøgningsbudget, taler vi normalt om de On-page og tekniske ændringer, Vi kan foretage for at øge gennemsøgningsbudgettet over tid. Imidlertid, kommer fra en linkbygningsbaggrund, de største pigge på gennemsøgte sider, vi ser i Google Search Console, vedrører direkte, når vi vinder store links til vores kunder.

ofte stillede spørgsmål om gennemsøgningsbudget

- 🧾 Hvad er et budget?

- larp hvordan øger jeg mit gennemsøgningsbudget?

- hvad kan begrænse mit gennemsøgningsbudget?

- skal jeg overhovedet bruge canonical URL og meta robots?

1. Hvad er et gennemsøgningsbudget?

gennemgå budget er antallet af sider søgemaskiner vil kravle på en hjemmeside inden for en bestemt tidsramme.

2. Hvordan øger jeg mit gennemsøgningsbudget?

Google har angivet, at der er en stærk sammenhæng mellem sideautoritet og gennemsøgningsbudget. Jo mere autoritet en side har, jo mere gennemsøgningsbudget har den. Kort sagt, for at øge dit gennemsøgningsbudget skal du opbygge din sides autoritet.

3. Hvad kan begrænse mit gennemsøgningsbudget?

krybe grænse, også kendt som krybe vært belastning, er baseret på mange faktorer, såsom hjemmesidens tilstand og hosting evner. Søgemaskinerne er indstillet til at forhindre overbelastning af en internetserver. Hvis din hjemmeside returnerer serverfejl, eller hvis de ønskede URL ‘ er timeout ofte, vil gennemsøgningsbudgettet være mere begrænset. Tilsvarende, hvis din hjemmeside kører på en delt hosting platform, vil gennemsøgningsgrænsen være højere, da du skal dele dit gennemsøgningsbudget med andre hjemmesider, der kører på hosting.

4. Skal jeg overhovedet bruge canonical URL og meta robots?

Ja, Og det er vigtigt at forstå forskellene mellem indekseringsproblemer og gennemsøgningsproblemer.

de kanoniske URL-og meta robots-tags sender et klart signal til søgemaskiner, hvilken side de skal vise i deres indeks, men det forhindrer dem ikke i at gennemgå de andre sider.

du kan bruge robotterne.link relation til håndtering af gennemsøgningsproblemer.