Genomsökningsbudget är antalet sidor sökmotorer kommer att genomsöka på en webbplats inom en viss tidsram.

sökmotorer beräknar genomsökningsbudget baserat på genomsökningsgräns (hur ofta de kan genomsöka utan att orsaka problem) och genomsökningsbehov (hur ofta de vill genomsöka en webbplats).

om du slösar bort genomsökningsbudget kommer sökmotorer inte att kunna genomsöka din webbplats effektivt, vilket skulle skada din SEO-prestanda.

- vad är crawl budget?

- varför tilldelar sökmotorer crawl-budget till webbplatser?

- hur tilldelar de crawl-budget till webbplatser?

- är crawl budget bara om sidor?

- hur fungerar crawl limit / host load i praktiken?

- hur fungerar crawl demand / crawl scheduling i praktiken?

- glöm inte: genomsökningskapacitet i själva systemet

- varför ska du bry dig om crawl budget?

- vad är crawl-budgeten för min webbplats?

- Genomsökningsbudget i Google Search Console

- gå till källan: serverloggar

- hur optimerar du din genomsökningsbudget?

- tillgängliga webbadresser med parametrar

- Duplicate content

- innehåll av låg kvalitet

- trasiga och omdirigera länkar

- felaktiga webbadresser i XML sitemaps

- ContentKing

- sidor med höga laddningstider / timeouts

- stort antal icke-indexerbara sidor

- Dålig intern länkstruktur

- Hur ökar du din webbplats crawl budget?

- Vanliga frågor om crawl budget

- 1. Vad är crawl budget?

- 2. Hur ökar jag min crawl budget?

- 3. Vad kan begränsa min crawl budget?

- 4. Ska jag använda canonical URL och meta robotar alls?

vad är crawl budget?

Genomsökningsbudget är antalet sidor som sökmotorer kommer att genomsöka på en webbplats inom en viss tidsram.

varför tilldelar sökmotorer crawl-budget till webbplatser?

eftersom de inte har obegränsade resurser, och de delar sin uppmärksamhet över miljontals webbplatser. Så de behöver ett sätt att prioritera sin krypningsinsats. Att tilldela crawl-budget till varje webbplats hjälper dem att göra detta.

hur tilldelar de crawl-budget till webbplatser?

det är baserat på två faktorer, crawl limit och crawl demand:

- Crawl limit / host load: hur mycket genomsökning kan en webbplats hantera, och vad är dess ägares preferenser?

- Crawl demand / crawl scheduling: vilka webbadresser som är värda (åter)genomsökning mest, baserat på dess popularitet och hur ofta den uppdateras.

Crawl budget är en vanlig term inom SEO. Crawl budget kallas ibland också crawl space eller crawl time.

är crawl budget bara om sidor?

det är faktiskt inte, för enkelhetens skull pratar vi om sidor, men i verkligheten handlar det om alla dokument som sökmotorer kryper. Några exempel på andra dokument: JavaScript-och CSS-filer, mobila sidvarianter, hreflang varianter och PDF-filer.

hur fungerar crawl limit / host load i praktiken?

Genomsökningsgräns, eller värdbelastning om du vill, är en viktig del av genomsökningsbudgeten. Sökmotorer är utformade för att förhindra överbelastning av en webbserver med förfrågningar så att de är försiktiga med detta.Hur sökmotorer bestämmer genomsökningsgränsen för en webbplats? Det finns en mängd olika faktorer som påverkar krypgränsen. För att nämna några:

- tecken på plattform i dålig form: hur ofta begärda webbadresser timeout eller retur serverfel.

- mängden webbplatser som körs på värden: om din webbplats körs på en delad värdplattform med hundratals andra webbplatser och du har en ganska stor webbplats är genomsökningsgränsen för din webbplats mycket begränsad eftersom genomsökningsgränsen bestäms på värdnivå. Du måste dela värdens genomsökningsgräns med alla andra webbplatser som körs på den. I det här fallet skulle du vara bättre på en dedikerad server, vilket sannolikt också kommer att minska belastningstiderna för dina besökare.

en annan sak att tänka på är att ha separata mobila och stationära webbplatser som körs på samma värd. De har också en gemensam krypgräns. Så ha detta i åtanke.

söker sökmotorer de viktigaste delarna av din webbplats? Kör ett snabbtest med ContentKing!

hur fungerar crawl demand / crawl scheduling i praktiken?

Crawl-efterfrågan, eller crawl-schemaläggning, handlar om att bestämma värdet av att genomsöka webbadresser igen. Igen, många faktorer påverkar crawl efterfrågan bland vilka:

- Popularitet: hur många inkommande interna och inkommande Externa Länkar en URL har, men också hur många frågor den rankar för.

- friskhet: hur ofta webbadressen uppdateras.

- typ av sida: är den typ av sida som sannolikt kommer att ändras. Ta till exempel en produktkategorisida och en villkorssida – vilken tycker du ändrar oftast och förtjänar att genomsökas oftare?

att tvinga Googles sökrobotar att komma tillbaka till din webbplats när det inte finns något viktigare att hitta (dvs. meningsfull förändring) är inte en bra strategi och de är ganska smarta för att ta reda på om frekvensen på dessa sidor förändras faktiskt tillför värde. Det bästa rådet jag kan ge är att koncentrera mig på att göra sidorna viktigare (lägga till mer användbar information, göra sidorna innehåll rika (de kommer naturligtvis att utlösa fler frågor som standard så länge fokus för ett ämne bibehålls). Genom att naturligt utlösa fler frågor som en del av’ recall ’ (visningar) gör du dina sidor viktigare och se och se: du kommer sannolikt att genomsökas oftare.

glöm inte: genomsökningskapacitet i själva systemet

medan sökmotorn genomsökningssystem har massiv genomsökningskapacitet, i slutet av dagen är det begränsat. Så i ett scenario där 80% av Googles datacenter går offline samtidigt minskar deras genomsökningskapacitet massivt och i sin tur alla webbplatsers genomsökningsbudget.

Massive tack vare Dawn Anderson (öppnas i en ny flik) för att ge oss information om crawl limit, crawl efterfrågan och crawl kapacitet!

varför ska du bry dig om crawl budget?

du vill att sökmotorer ska hitta och förstå så många som möjligt av dina indexerbara sidor, och du vill att de ska göra det så snabbt som möjligt. När du lägger till nya sidor och uppdaterar befintliga, vill du att sökmotorer ska hämta dessa så snart som möjligt. Ju tidigare de har indexerat sidorna, desto tidigare kan du dra nytta av dem.

om du slösar bort genomsökningsbudget kommer sökmotorer inte att kunna genomsöka din webbplats effektivt. De kommer att spendera tid på delar av din webbplats som inte spelar någon roll, vilket kan leda till att viktiga delar av din webbplats lämnas oupptäckta. Om de inte känner till sidor kommer de inte att genomsöka och indexera dem, och du kommer inte att kunna ta in besökare via sökmotorer till dem.

du kan se var detta leder till: slösa crawl budget skadar din SEO prestanda.

Observera att genomsökningsbudget i allmänhet bara är något att oroa sig för om du har en stor webbplats, låt oss säga 10 000 sidor och uppåt.

en av de mer underskattade aspekterna av crawl-budgeten är lasthastighet. En snabbare laddningswebbplats innebär att Google kan genomsöka fler webbadresser på samma tid. Nyligen var jag inblandad i en webbplatsuppgradering där lasthastigheten var ett stort fokus. Den nya webbplatsen laddas dubbelt så snabbt som den gamla. När det drevs live ökade antalet webbadresser som Google genomsökte per dag från 150 000 till 600 000 – och stannade där. För en webbplats av denna storlek och omfattning innebär den förbättrade genomsökningshastigheten att nytt och förändrat innehåll genomsöks mycket snabbare, och vi ser en mycket snabbare inverkan av våra SEO-ansträngningar i SERP.

en mycket klok SEO (okej, det var AJ Kohn (öppnas i en ny flik)) en gång berömd sa ”Du är vad Googlebot äter.”. Din ranking och söksynlighet är direkt relaterad till inte bara vad Google genomsöker på din webbplats, men ofta, hur ofta de genomsöker den. Om Google saknar innehåll på din webbplats eller inte genomsöker viktiga webbadresser tillräckligt ofta på grund av begränsad/ooptimerad genomsökningsbudget, kommer du verkligen att ha svårt att ranka. För större webbplatser kan optimering av genomsökningsbudgeten öka profilen för tidigare osynliga sidor. Medan mindre webbplats behöver oroa sig mindre om crawl budget, samma principer för optimering (hastighet, prioritering, länkstruktur, de-duplicering, etc.) kan fortfarande hjälpa dig att rangordna.

jag håller mest med Google och för det mesta behöver många webbplatser inte oroa sig för genomsökningsbudget. Men för webbplatser som är stora i storlek och särskilt de som uppdateras ofta som utgivare kan optimering göra en betydande skillnad.

vad är crawl-budgeten för min webbplats?

av alla sökmotorer är Google den mest transparenta om deras genomsökningsbudget för din webbplats.

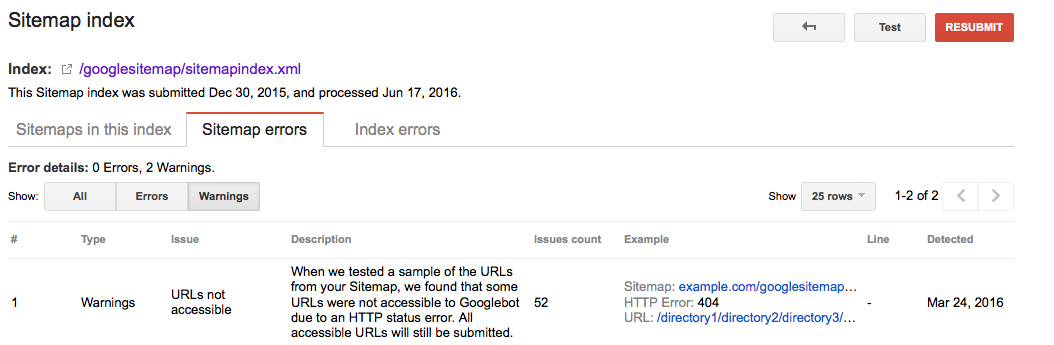

Genomsökningsbudget i Google Search Console

om du har verifierat din webbplats i Google Search Console kan du få lite inblick i webbplatsens genomsökningsbudget för Google.

följ dessa steg:

- logga in på Google Search Console och välj en webbplats.

- gå till

Crawl>Crawl Stats. Där kan du se antalet sidor som Google genomsöker per dag.

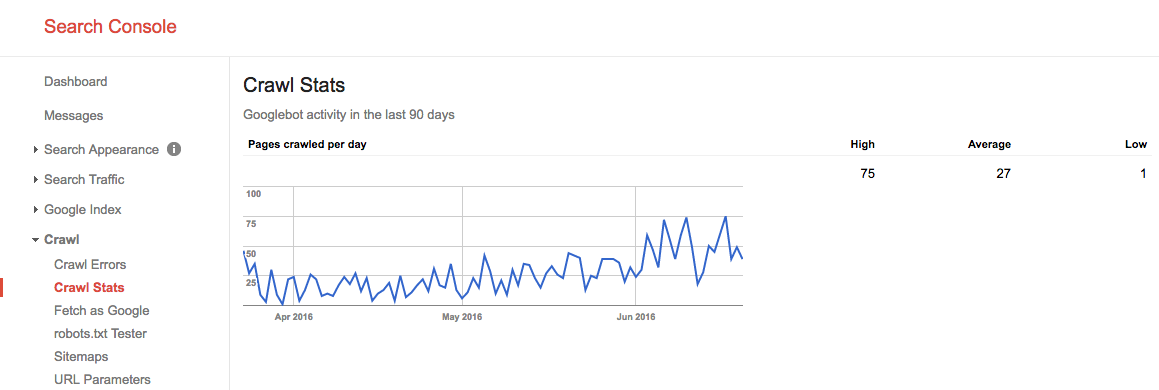

under sommaren 2016 såg vår genomsökningsbudget ut så här:

vi ser här att den genomsnittliga genomsökningsbudgeten är 27 sidor / dag. Så i teorin, om den genomsnittliga genomsökningsbudgeten förblir densamma, skulle du ha en månatlig genomsökningsbudget på 27 sidor x 30 dagar = 810 sidor.

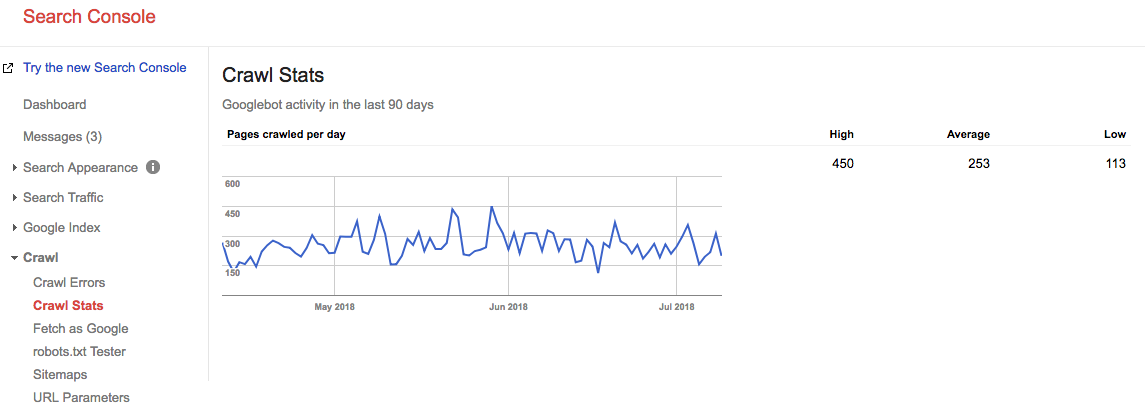

spola framåt 2 år, och titta på vad vår crawl budget är just nu:

vår genomsnittliga genomsnittliga genomsökningsbudget är 253 sidor / dag, så du kan säga att vår genomsökningsbudget gick upp 10X om 2 år.

gå till källan: serverloggar

det är väldigt intressant att kontrollera dina serverloggar för att se hur ofta Googles sökrobotar träffar din webbplats. Det är intressant att jämföra denna statistik med de som rapporteras i Google Search Console. Det är alltid bättre att förlita sig på flera källor.

låt inte genomsökningsproblem vara ett missat tillfälle. Kontinuerligt övervaka din webbplats med ContentKing och varnas för problem i realtid.

hur optimerar du din genomsökningsbudget?

optimera din genomsökningsbudget handlar om att se till att ingen genomsökningsbudget slösas bort. I huvudsak fastställa orsakerna till bortkastad crawl budget. Vi övervakar tusentals webbplatser; om du skulle kontrollera var och en av dem för crawl budgetfrågor, skulle du snabbt se ett mönster: de flesta webbplatser lider av samma typ av problem.

vanliga orsaker till bortkastad genomsökningsbudget som vi stöter på:

- tillgängliga webbadresser med parametrar: ett exempel på en webbadress med en parameter är

https://www.example.com/toys/cars?color=black. I det här fallet används parametern för att lagra en besökares val i ett produktfilter. - duplicerat innehåll: vi kallar sidor som är mycket lika, eller exakt samma, ”duplicerat innehåll.”Exempel är: kopierade sidor, interna sökresultatsidor och taggsidor.

- innehåll av låg kvalitet: sidor med mycket lite innehåll eller sidor som inte tillför något värde.

- trasiga och omdirigerande länkar: trasiga länkar är länkar som refererar till sidor som inte finns längre, och omdirigerade länkar är länkar till webbadresser som omdirigerar till andra webbadresser.

- inklusive felaktiga webbadresser i XML-webbplatskartor: icke-indexerbara sidor och icke-sidor som 3xx, 4xx och 5xx-webbadresser bör inte inkluderas i din XML-webbplatskarta.

- sidor med hög laddningstid / time-outs: sidor som tar lång tid att ladda, eller inte alls, har en negativ inverkan på din genomsökningsbudget, eftersom det är ett tecken för sökmotorer att din webbplats inte kan hantera begäran, och så kan de justera din genomsökningsgräns.

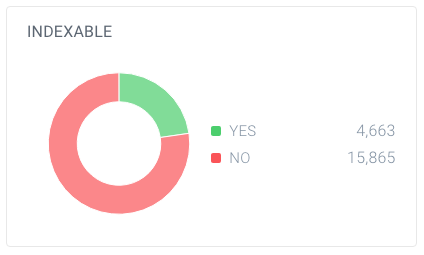

- stort antal icke-indexerbara sidor: webbplatsen innehåller många sidor som inte kan indexeras.

- Dålig intern länkstruktur: om din interna länkstruktur inte är korrekt inställd kanske sökmotorer inte uppmärksammar några av dina sidor.

jag har ofta sagt att Google är som din chef. Du skulle inte gå in i ett möte med din chef om du inte visste vad du skulle prata om, höjdpunkterna i ditt arbete, målen för ditt möte. Kort sagt, du har en agenda. När du går in i Googles ”kontor” behöver du samma sak. En tydlig webbplatshierarki utan mycket cruft, en användbar XML-webbplatskarta och snabba svarstider kommer alla att hjälpa Google att komma till det som är viktigt. Glöm inte detta ofta missförstådda element i SEO.

för mig är begreppet crawl budget en av de viktigaste punkterna i teknisk SEO. När du optimerar för genomsökningsbudgeten faller allt annat på plats: intern länkning, fixeringsfel, sidhastighet, URL-optimering, innehåll av låg kvalitet och mer. Människor bör gräva i sina loggfiler oftare för att övervaka crawl budget för specifika webbadresser, underdomäner, katalog, etc. Övervakning crawl frekvens är mycket relaterad till crawl budget och super kraftfull.

tillgängliga webbadresser med parametrar

i de flesta fall bör webbadresser med parametrar inte vara tillgängliga för sökmotorer, eftersom de kan generera en praktiskt taget oändlig mängd webbadresser.Vi har skrivit mycket om denna typ av problem i vår artikel om sökrobotar.

webbadresser med parametrar används ofta vid implementering av produktfilter på e-handelswebbplatser. Det är bra att använda dem,; se bara till att de inte är tillgängliga för sökmotorer.

Hur kan du göra dem otillgängliga för sökmotorn?

- Använd dina robotar.txt-fil för att instruera sökmotorer att inte komma åt sådana webbadresser. Om detta av någon anledning inte är ett alternativ kan du använda inställningarna för hantering av URL-parametrar i Google Search Console och Bings verktyg för webbansvariga för att instruera Google och Bing om vilka sidor som inte ska genomsökas.

- Lägg till attributvärdet nofollow till länkar på filterlänkar. Observera att från och med mars 2020 kan Google välja att ignorera nofollow. Därför är steg 1 ännu viktigare.

Duplicate content

du vill inte att sökmotorn ska spendera sin tid på duplicerade innehållssidor, så det är viktigt att förhindra eller åtminstone minimera duplicerat innehåll på din webbplats.

Hur gör du det här? Av…

- ställa in Webbplats omdirigeringar för alla domänvarianter (

HTTP,HTTPS,non-WWW, ochWWW). - gör interna sökresultatsidor otillgängliga för sökmotorer med dina robotar.txt. Här är ett exempel robotar.txt för en WordPress-webbplats.

- inaktivera dedikerade sidor för bilder (till exempel: de ökända bildbilagesidorna i WordPress).

- var försiktig med din användning av taxonomier som kategorier och taggar.

kolla in några mer tekniska skäl för duplicerat innehåll och hur du fixar dem.

innehåll av låg kvalitet

sidor med mycket lite innehåll är inte intressanta för sökmotorer. Håll dem till ett minimum, eller undvik dem helt om möjligt. Ett exempel på innehåll av låg kvalitet är en FAQ-sektion med länkar för att visa frågor och svar, där varje fråga och svar serveras över en separat URL.

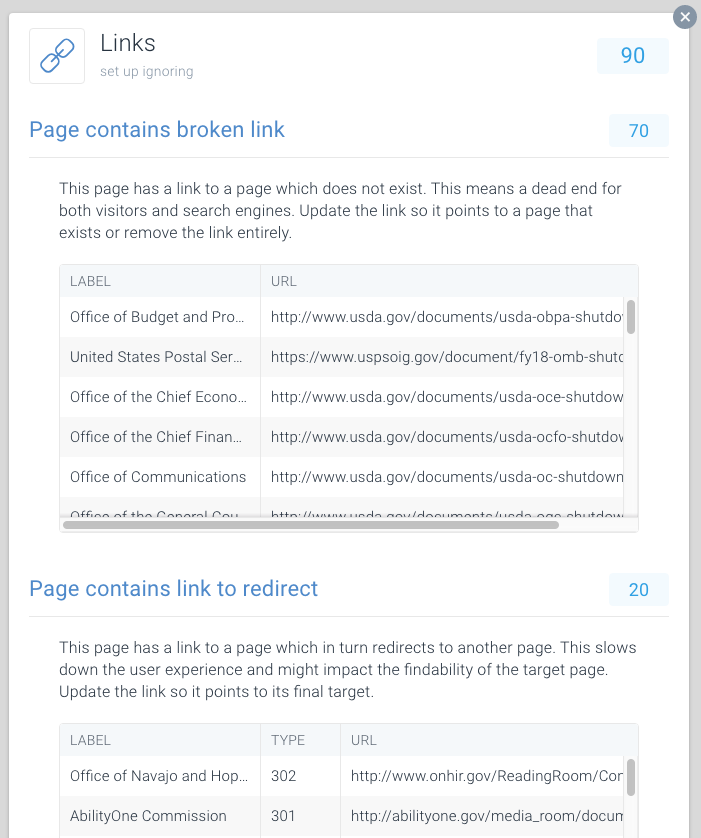

trasiga och omdirigera länkar

trasiga länkar och långa kedjor av omdirigeringar är återvändsgränder för sökmotorer. I likhet med webbläsare verkar Google följa högst fem kedjade omdirigeringar i en genomsökning (de kan återuppta genomsökning senare). Det är oklart hur väl andra sökmotorer hantera efterföljande omdirigeringar, men vi rekommenderar starkt att du undviker kedjade omdirigeringar helt och hålla användningen av omdirigeringar till ett minimum.

det är uppenbart att genom att fixa trasiga länkar och omdirigera länkar kan du snabbt återställa bortkastad genomsökningsbudget. Förutom att återställa crawl budget, du också avsevärt förbättra en besökares användarupplevelse. Omdirigeringar, och kedjor av omdirigeringar i synnerhet, orsaka längre sidan laddningstid och därmed skada användarupplevelsen.

för att göra det enkelt att hitta trasiga och omdirigera länkar har vi dedikerat speciella problem till detta inom ContentKing.

gå till Issues > Links för att ta reda på om du slösar bort genomsökningsbudgetar på grund av felaktiga länkar. Uppdatera varje länk så att den länkar till en indexerbar sida, eller ta bort länken om den inte längre behövs.

felaktiga webbadresser i XML sitemaps

alla webbadresser som ingår i XML sitemaps bör vara för indexerbara sidor. Speciellt med stora webbplatser är sökmotorer starkt beroende av XML-webbplatskartor för att hitta alla dina sidor. Om dina XML-webbplatskartor är röriga med sidor som till exempel inte finns längre eller omdirigerar, slösar du bort genomsökningsbudgeten. Kontrollera regelbundet din XML-webbplatskarta för icke-indexerbara webbadresser som inte hör hemma där. Kontrollera också motsatsen: leta efter sidor som är felaktigt uteslutna från XML-webbplatskartan. XML sitemap är ett bra sätt att hjälpa sökmotorer spendera crawl budget klokt.

Google Searche Console

- logga in på Google Search Console

- klicka på fliken

Crawl - klicka på fliken

Sitemaps

Bing verktyg för webbansvariga

- logga in på ditt Bing Webmaster Tools-konto

- klicka på fliken

Configure My Site - klicka på fliken

Sitemaps

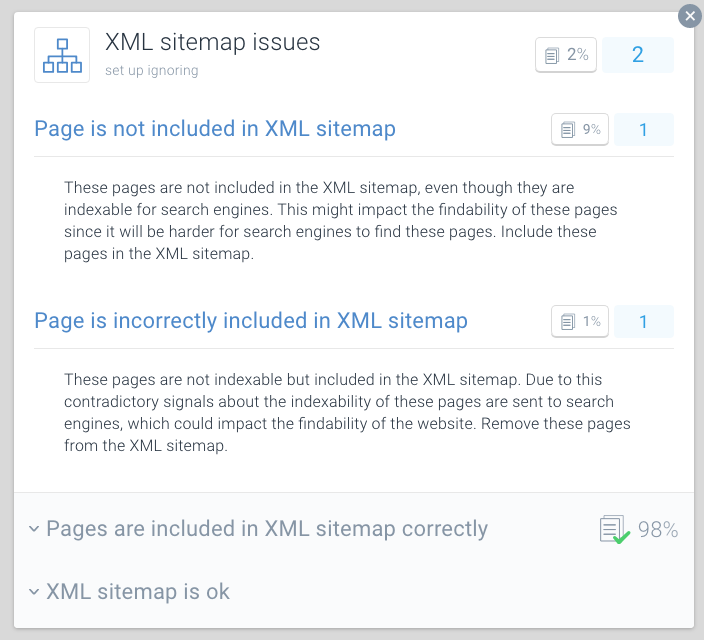

ContentKing

- logga in på ditt ContentKing-konto

- klicka på

Issuesknappen - klicka på

XML Sitemapknappen - vid problem med din sida får du det här meddelandet:

Page is incorrectly included in XML sitemap

en bästa praxis för crawl-budget optimering är att dela upp dina XML sitemaps upp i mindre webbplatskartor. Du kan till exempel skapa XML-webbplatskartor för var och en av webbplatsens avsnitt. Om du har gjort detta kan du snabbt avgöra om det finns några problem på vissa delar av din webbplats.

säg att din XML-webbplatskarta för avsnitt A innehåller 500 länkar och 480 är indexerade: då gör du ganska bra. Men om din XML-webbplatskarta för avsnitt B innehåller 500 länkar och bara 120 indexeras, är det något att titta på. Du kan ha inkluderat många icke-indexerbara webbadresser i XML-webbplatskartan för Avsnitt B.

dåliga förhållanden för sökrobotar kan skada din SEO. Använd ContentKing för att göra en snabb granskning av din webbplats.

sidor med höga laddningstider / timeouts

när sidor har höga laddningstider eller de timeout kan sökmotorer besöka färre sidor inom sin tilldelade genomsökningsbudget för din webbplats. Förutom den nackdelen skadar höga sidladdningstider och timeout din besökares användarupplevelse avsevärt, vilket resulterar i en lägre omvandlingsfrekvens.

sidladdningstider över två sekunder är ett problem. Helst laddas din sida på under en sekund. Kontrollera regelbundet dina sidladdningstider med verktyg som Pingdom (öppnas i en ny flik), WebPagetest (öppnas i en ny flik) eller GTmetrix (öppnas i en ny flik).

Google rapporterar om sidladdningstid i både Google Analytics (under Behavior > Site Speed) och Google Search Console under Crawl > Crawl Stats.

Google Search Console och Bing Webmaster Tools rapporterar båda om tidsgränser för sidor. I Google Search Console kan detta hittas under Crawl > Crawl Errors, och i Bing Webmaster Tools är det under Reports & Data > Crawl Information.

Kontrollera regelbundet för att se om dina sidor laddas tillräckligt snabbt och vidta åtgärder omedelbart om de inte är det. Snabbmatade sidor är avgörande för din online-framgång.

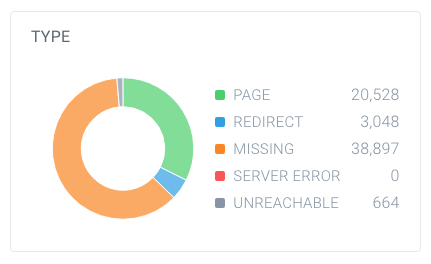

stort antal icke-indexerbara sidor

om din webbplats innehåller ett stort antal icke-indexerbara sidor som är tillgängliga för sökmotorer, håller du i princip sökmotorerna upptagna med att söka igenom irrelevanta sidor.

vi anser att följande typer är icke-indexerbara sidor:

- omdirigeringar (3xx)

- sidor som inte kan hittas (4xx)

- sidor med serverfel (5xx)

- sidor som inte kan indexeras (sidor som innehåller robots noindex-direktivet eller canonical URL)

för att ta reda på om du har ett stort antal icke-indexerbara sidor, leta upp det totala antalet sidor som sökrobotar har hittat på din webbplats och hur de bryts ner. Du kan enkelt göra detta med ContentKing:

i det här exemplet finns det 63 137 webbadresser, varav endast 20 528 sidor.

och av dessa sidor är endast 4 663 indexerbara för sökmotorer. Endast 7,4% av webbadresserna som hittas av ContentKing kan indexeras av sökmotorer. Det är inte ett bra förhållande, och den här webbplatsen behöver definitivt arbeta med det genom att städa upp alla referenser till dem som är onödiga, inklusive:

- XML sitemap (se föregående avsnitt)

- länkar

- kanoniska webbadresser

- hreflang referenser

- Pagination referenser (länk rel föregående / nästa)

Dålig intern länkstruktur

hur sidor på din webbplats länkar till varandra spelar en stor roll i genomsökningsbudgetoptimering. Vi kallar detta den interna länkstrukturen på din webbplats. Bakåtlänkar åt sidan, sidor som har få Interna Länkar får mycket mindre uppmärksamhet från sökmotorer än sidor som är länkade till av många sidor.

Undvik en mycket hierarkisk länkstruktur, med sidor i mitten med få länkar. I många fall kommer dessa sidor inte att genomsökas ofta. Det är ännu värre för sidor längst ner i hierarkin: på grund av deras begränsade mängd länkar kan de mycket väl försummas av sökmotorer.

se till att dina viktigaste sidor har gott om interna länkar. Sidor som nyligen har genomsökts rankas vanligtvis bättre i sökmotorer. Tänk på detta och justera din interna länkstruktur för detta.

om du till exempel har en bloggartikel från 2011 som driver mycket organisk trafik, se till att du fortsätter att länka till den från annat innehåll. Eftersom du har producerat många andra bloggartiklar genom åren trycks den artikeln från 2011 automatiskt ner i webbplatsens interna länkstruktur.

du behöver vanligtvis inte oroa dig för genomsökningsgraden för dina viktiga sidor. Det är oftast sidor som är nya, att du inte länka till, och att människor inte kommer att som inte kan genomsökas ofta.

Hur ökar du din webbplats crawl budget?

under en intervju (öppnas i en ny flik) mellan Eric Enge och Googles tidigare chef för webspam-teamet Matt Cutts togs förhållandet mellan myndighet och genomsökningsbudget upp:

det bästa sättet att tänka på det är att antalet sidor som vi genomsöker är ungefär proportionellt mot din PageRank. Så om du har många inkommande länkar på din rotsida, kommer vi definitivt att genomsöka det. Då kan din rotsida länka till andra sidor, och de kommer att få PageRank och vi kommer också att genomsöka dem. När du blir djupare och djupare på din webbplats tenderar PageRank dock att minska.

även om Google har övergivit uppdatering av PageRank – värden på sidor offentligt, tror vi (en form av) PageRank fortfarande används i deras algoritmer. Eftersom PageRank är en missförstådd och förvirrande term, låt oss kalla det sidmyndighet. Take-away här är att Matt Cutts i princip säger: Det finns en ganska stark relation mellan page authority och crawl budget.

så för att öka din webbplats genomsökningsbudget måste du öka auktoriteten på din webbplats. En stor del av detta görs genom att tjäna fler länkar från externa webbplatser. Mer information om detta finns i vår länkbyggnadsguide.

när jag hör branschen talar om crawl budget, Vi brukar tala om på sidan och tekniska förändringar Vi kan göra för att öka crawl budget över tiden. Men från en länkbyggnadsbakgrund relaterar de största spikarna på genomsökta sidor Vi ser i Google Search Console direkt till när vi vinner stora länkar för våra kunder.

Vanliga frågor om crawl budget

- 🧾 vad är crawl budget?

- Brasilien Hur ökar jag min genomsökningsbudget?

- Brasilien vad kan begränsa min genomsökningsbudget?

- borde jag använda canonical URL och meta robotar alls?

1. Vad är crawl budget?

Genomsökningsbudget är antalet sidor som sökmotorer kommer att genomsöka på en webbplats inom en viss tidsram.

2. Hur ökar jag min crawl budget?

Google har angett att det finns en stark relation mellan sidmyndighet och genomsökningsbudget. Ju mer auktoritet en sida har, desto mer genomsökningsbudget har den. Enkelt uttryckt, för att öka din genomsökningsbudget, Bygg din sidas auktoritet.

3. Vad kan begränsa min crawl budget?

Crawl limit, även känd som crawl host load, är baserad på många faktorer, såsom webbplatsens skick och hosting förmågor. Sökrobotar är inställda för att förhindra överbelastning av en webbserver. Om din webbplats returnerar serverfel, eller om de begärda webbadresserna tar slut ofta, kommer genomsökningsbudgeten att vara mer begränsad. På samma sätt, om din webbplats körs på en delad värdplattform, kommer genomsökningsgränsen att vara högre eftersom du måste dela din genomsökningsbudget med andra webbplatser som körs på webbhotellet.

4. Ska jag använda canonical URL och meta robotar alls?

Ja, och det är viktigt att förstå skillnaderna mellan indexeringsproblem och genomsökningsproblem.

taggarna canonical URL och meta robots skickar en tydlig signal till sökmotorerna vilken sida de ska visa i sitt index, men det hindrar dem inte från att genomsöka de andra sidorna.

du kan använda robotarna.txt-fil och nofollow länk relation för att hantera crawl frågor.